نموذج اللغة العميق الجديد في الصين (LLM) السوق الذي يهيمن عليه الولايات المتحدة ، حيث قدم نموذج chatbot عالي الأداء نسبيًا بتكلفة أقل بكثير.

ساهمت التكلفة المنخفضة للتطوير وانخفاض أسعار الاشتراك مقارنةً بأدوات الذكاء الاصطناعى في الولايات المتحدة في خسارة صانع الرقائق الأمريكية Nvidia 600 مليار دولار (480 مليار جنيه إسترليني) في القيمة السوقية خلال يوم واحد. تجعل Nvidia رقائق الكمبيوتر المستخدمة لتدريب غالبية LLMs ، والتكنولوجيا الأساسية المستخدمة في ChatGPT وغيرها من chatbots AI. يستخدم Deepseek رقائق Nvidia H800 أرخص على الإصدارات الأكثر تكلفة.

وبحسب ما ورد أنفق مطور ChatGPT Openai في مكان ما بين 100 مليون دولار أمريكي و 1 مليار دولار أمريكي على تطوير نسخة حديثة جدًا من منتجه يسمى O1. في المقابل ، أنجزت Deepseek تدريبها في شهرين فقط بتكلفة 5.6 مليون دولار أمريكي باستخدام سلسلة من الابتكارات الذكية.

ولكن إلى أي مدى يقارن Deepseek من AI chatbot ، R1 ، مع أدوات أخرى من الذكاء الاصطناعى المماثلة في الأداء؟

تدعي Deepseek أن نماذجها تؤدي عروض Openai بشكل مماثل ، حتى تجاوز نموذج O1 في بعض الاختبارات القياسية. ومع ذلك ، فإن المعايير التي تستخدم اختبارات فهم لغة متعددة المهام (MMLU) تقييم المعرفة عبر مواضيع متعددة باستخدام أسئلة الاختيار من متعدد. يتم تدريب العديد من LLMs وتحسينها لمثل هذه الاختبارات ، مما يجعلها غير موثوق بها كمؤشرات حقيقية للأداء في العالم الحقيقي.

تستخدم منهجية بديلة للتقييم الموضوعي لـ LLMS مجموعة من الاختبارات التي طورها الباحثون في جامعات كارديف متروبوليتان وبريستول وكارديف - المعروفة مجتمعة باسم مجموعة مراقبة المعرفة (KOG). هذه الاختبارات تحقق في قدرة LLMS على محاكاة اللغة البشرية والمعرفة من خلال الأسئلة التي تتطلب فهم الإنسان الضمني للإجابة. يتم الحفاظ على الاختبارات الأساسية سرية ، لتجنب شركات LLM تدريب نماذجها على هذه الاختبارات.

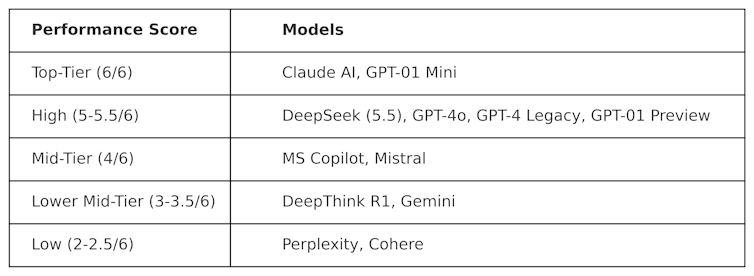

نشرت KOG اختبارات عامة مستوحاة من العمل من قبل كولن فريزر ، عالم البيانات في META ، لتقييم Deepseek ضد LLMs الأخرى. وقد لوحظت النتائج التالية:

الاختبارات المستخدمة لإنتاج هذا الجدول هي "خصومة" في الطبيعة. بمعنى آخر ، تم تصميمها لتكون "صعبة" واختبار LLMs بطريقة لا تتعاطف مع كيفية تصميمها. هذا يعني أن أداء هذه النماذج في هذا الاختبار من المحتمل أن يكون مختلفًا عن أدائها في اختبارات القياس السائدة.

سجل Deepseek 5.5 من أصل 6 ، يتفوق على Openai's O1-التفكير المتقدم (المعروف باسم "سلسلة الفكرة")-بالإضافة إلى chatgpt-4o ، الإصدار المجاني من ChatGpt. لكن Deepseek تفوقت بشكل هامشي من قبل Claudeai's Anthropic's Claudeai و Openai's O1 Mini ، وكلاهما سجل 6/6 مثالي. من المثير للاهتمام أن O1 كان أداء O1 ضد نظيره "الأصغر" ، O1 Mini.

DeepThink R1-وهي أداة منظمة العفو الدولية التي تصنعها Deepseek-أقل من الأداء مقارنة بـ Deepseek مع درجة 3.5.

توضح هذه النتيجة مدى تنافسية Deepseek's chatbot بالفعل ، حيث تغلب على نماذج Openai الرائدة. من المحتمل أن تحفز المزيد من التطوير لـ Deepseek ، التي لديها الآن أساس قوي للبناء عليه. ومع ذلك ، فإن شركة التكنولوجيا الصينية لديها مشكلة خطيرة واحدة لا تتعلق LLMs الأخرى: الرقابة.

تحديات الرقابة

على الرغم من أدائها القوي وشعبيتها ، واجهت Deepseek انتقادات بشأن ردودها على الموضوعات الحساسة سياسيا في الصين. على سبيل المثال ، يقابل المطالبة المتعلقة بميدان تيانانمن وتايوان ومسلمي أويغور والحركات الديمقراطية بالرد: "آسف ، هذا يتجاوز النطاق الحالي".

لكن هذه المسألة ليست فريدة بالضرورة لـ Deepseek ، كما أن إمكانية التأثير السياسي والرقابة في LLMS هي مصدر قلق متزايد بشكل عام. الإعلان عن مشروع Donald Trump 500 مليار دولار أمريكي Stargate LLM ، الذي يشمل Openai و Nvidia و Oracle و Microsoft و Arm ، مخاوف من التأثير السياسي.

بالإضافة إلى ذلك ، يشير قرار Meta الأخير بالتخلي عن التحقق من الحقائق على Facebook و Instagram إلى اتجاه متزايد نحو الشعوبية على الصدق.

المحتوى من شركائنا

تسبب وصول ديبسيك في اضطراب خطير في سوق LLM. ستضطر الشركات الأمريكية مثل Openai و Anthropic إلى ابتكار منتجاتها للحفاظ على الأهمية ومطابقة أدائها وتكلفةها.

يتحدى نجاح Deepseek بالفعل الوضع الراهن ، مما يدل على أنه يمكن تطوير نماذج LLM عالية الأداء دون ميزانيات مليار دولار. كما يسلط الضوء على مخاطر الرقابة LLM ، وانتشار المعلومات الخاطئة ، ولماذا يهم التقييمات المستقلة.

نظرًا لأن LLMs أصبحت مضمنة بشكل أعمق في السياسة والأعمال العالمية ، فإن الشفافية والمساءلة ستكون ضرورية لضمان أن يكون مستقبل LLMs آمنًا ومفيدًا وجديرًا بالثقة.

سيمون ثورن ، محاضر كبير في أنظمة الحوسبة والمعلومات ، جامعة كارديف متروبوليتان ،

يتم إعادة نشر هذه المقالة من المحادثة بموجب ترخيص العموم الإبداعي. اقرأ المقال الأصلي .