Fehlinformationen im Internet haben erhebliche Konsequenzen für das wirkliche Leben, wie zum Beispiel Masernausbrüche und die Förderung rassistischer Massenmörder . Fehlinformationen im Internet können auch politische Konsequenzen haben.

Das Problem der Desinformation und Propaganda, die Social-Media-Nutzer in die Irre führten, war 2016 ernst, hielt 2018 unvermindert an und dürfte im kommenden Wahlzyklus 2020 in den USA

Die meisten Menschen denken, sie könnten Täuschungsbemühungen im Internet erkennen, aber in unserer jüngsten Untersuchung weniger als 20 % der Teilnehmer tatsächlich in der Lage, absichtlich irreführende Inhalte richtig zu identifizieren. Der Rest schnitt nicht besser ab, als wenn er eine Münze geworfen hätte, um zu entscheiden, was echt ist und was nicht.

Sowohl psychologische als auch neurologische Beweise zeigen, dass Menschen eher Informationen glauben und ihnen Aufmerksamkeit schenken, die mit ihren politischen Ansichten übereinstimmen – unabhängig davon, ob sie wahr sind. Sie misstrauen und ignorieren Beiträge, die nicht mit dem übereinstimmen, was sie bereits denken.

Als Informationssystemforscher wollten wir Wege finden, Menschen dabei zu helfen, wahre und falsche Informationen zu unterscheiden – unabhängig davon, ob sie ihre bisherige Meinung bestätigten oder nicht und selbst wenn sie aus unbekannten Quellen stammten. Die Faktenprüfung einzelner Artikel ist ein guter Anfang, kann aber Tage dauern und ist daher normalerweise nicht schnell genug, um mit der Geschwindigkeit der Nachrichtenverbreitung Schritt zu halten .

Unser Ziel war es, den effektivsten Weg zu finden, den Genauigkeitsgrad einer Quelle der Öffentlichkeit zu präsentieren – also den Weg, der den größten Effekt auf die Reduzierung des Glaubens an Desinformation und deren Verbreitung hat.

Experten- oder Nutzerbewertungen?

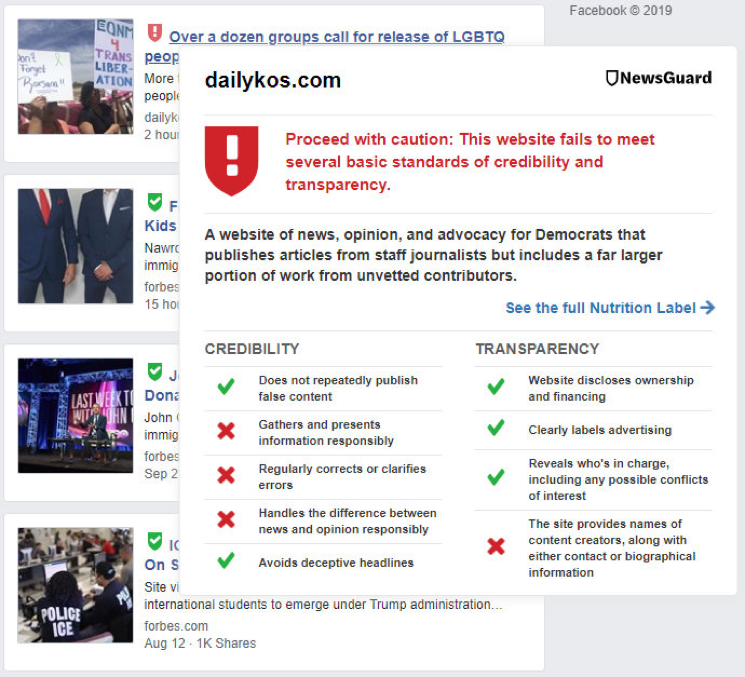

Eine Alternative ist eine Quellenbewertung, die auf früheren Artikeln basiert und jedem neuen Artikel bei seiner Veröffentlichung beigefügt wird, ähnlich wie die Verkäuferbewertungen bei Amazon oder eBay.

Die nützlichsten Bewertungen sind diejenigen, die eine Person zum relevantesten Zeitpunkt verwenden kann – zum Beispiel um sich über die Erfahrungen früherer Käufer mit einem Verkäufer zu informieren, wenn sie über einen Online-Kauf nachdenken.

Wenn es um Fakten geht, gibt es jedoch noch einen weiteren Haken. E-Commerce-Bewertungen werden in der Regel von regelmäßigen Benutzern vorgenommen, also von Personen, die aus erster Hand über die Nutzung des Artikels oder der Dienstleistung Bescheid wissen.

Die Faktenprüfung hingegen wird traditionell von Experten wie PolitiFact , da nur wenige Menschen über das Wissen aus erster Hand verfügen, um Nachrichten zu bewerten. Durch den Vergleich von benutzergenerierten Bewertungen und von Experten erstellten Bewertungen haben wir festgestellt, dass unterschiedliche Bewertungsmechanismen die Benutzer auf unterschiedliche Weise beeinflussen .

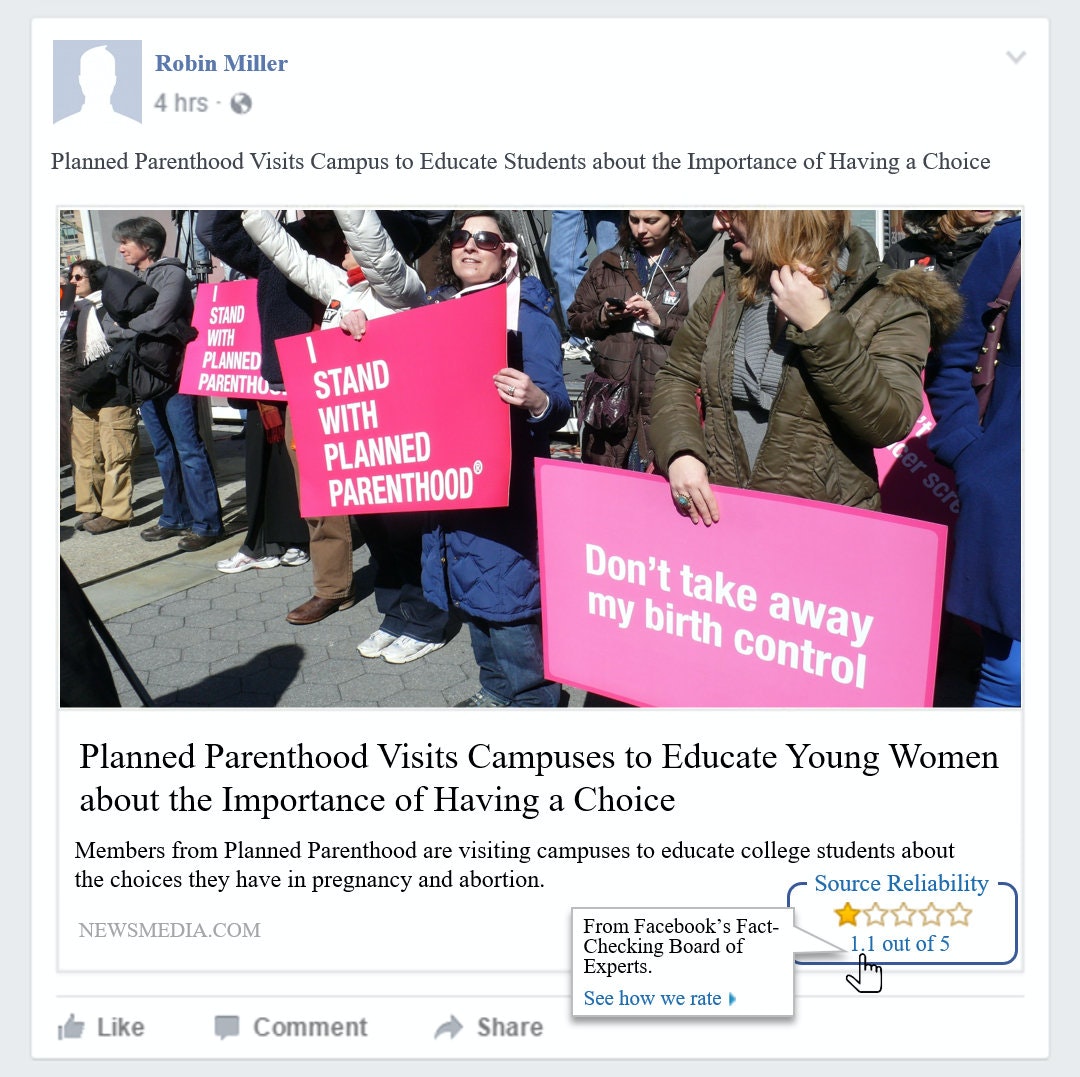

Wir führten zwei Online-Experimente mit insgesamt 889 Teilnehmern durch. Jeder Person wurde eine Gruppe von Schlagzeilen angezeigt, von denen einige mit Genauigkeitsbewertungen von Experten versehen waren, andere mit Bewertungen anderer Benutzer und die übrigen ohne jegliche Genauigkeitsbewertungen.

Wir haben die Teilnehmer gefragt, inwieweit sie den einzelnen Schlagzeilen Glauben schenken und ob sie den Artikel lesen, liken, kommentieren oder teilen würden.

Kim et al. , CC BY-ND

Kim et al. , CC BY-ND

Expertenbewertungen von Nachrichtenquellen wirkten sich stärker auf die Überzeugung aus als Bewertungen von nicht fachkundigen Benutzern, und die Auswirkungen waren sogar noch stärker, wenn die Bewertung niedrig war, was darauf hindeutet, dass die Quelle wahrscheinlich ungenau war. Diese schlecht bewerteten, ungenauen Quellen sind die üblichen Übeltäter bei der Verbreitung von Desinformation. Unsere Ergebnisse deuten also darauf hin, dass Expertenbewertungen dann noch aussagekräftiger sind, wenn Benutzer sie am meisten benötigen.

Der Glaube der Befragten an eine Überschrift beeinflusste das Ausmaß, in dem sie sich damit beschäftigen würden: Je mehr sie glaubten, dass ein Artikel wahr sei, desto wahrscheinlicher war es, dass sie den Artikel lasen, mit „Gefällt mir“ markierten, kommentierten oder teilten.

Diese Ergebnisse zeigen uns, dass es dazu beitragen kann, die Verbreitung von Desinformation einzudämmen, indem man Benutzern hilft, falschem Material in dem Moment, in dem sie darauf stoßen, zu misstrauen.

Spillover-Effekte

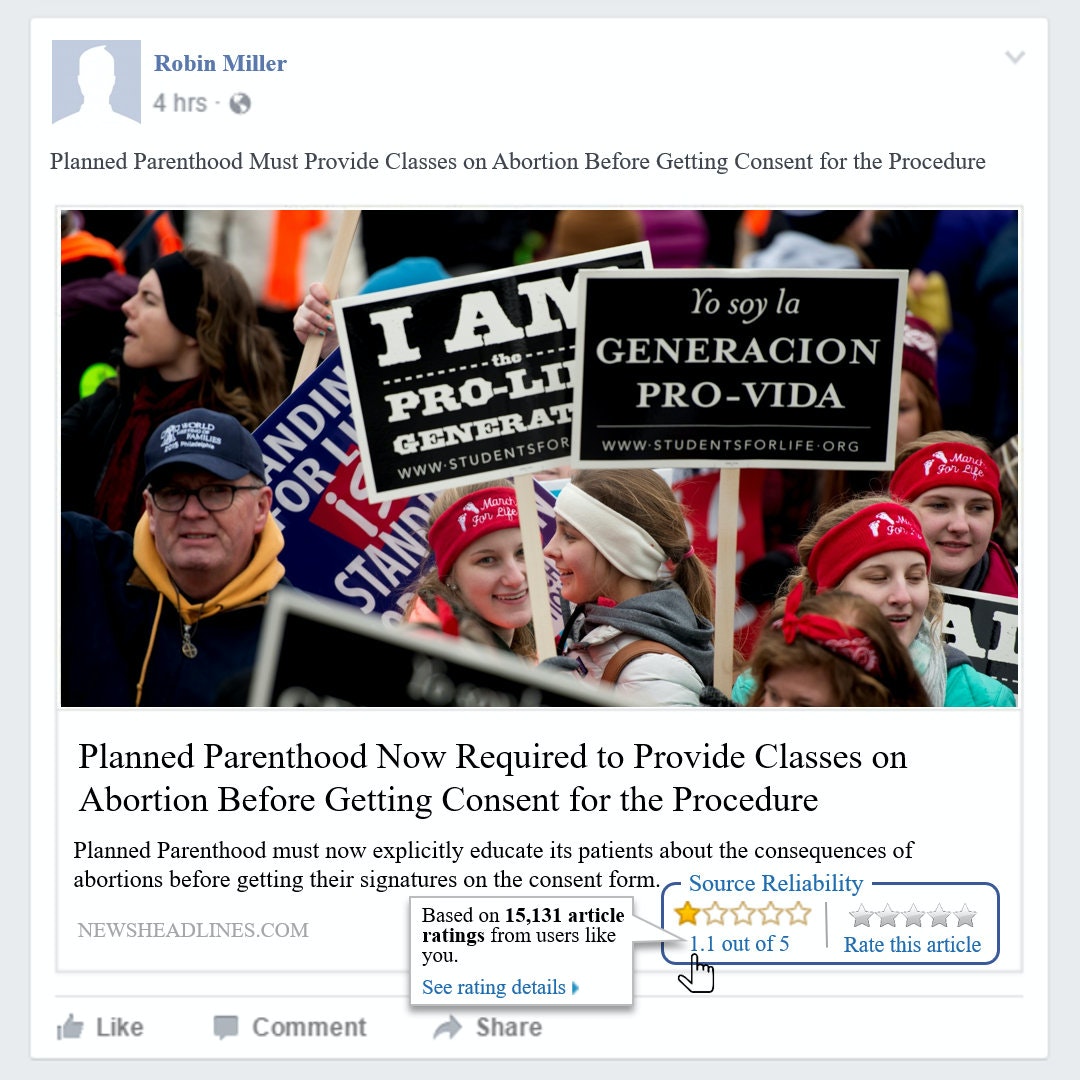

Wir haben außerdem festgestellt, dass die Anwendung von Quellenbewertungen auf einige Schlagzeilen gegenüber anderen Schlagzeilen ohne Bewertungen skeptischer wurden

Inhalte unserer Partner

Kim et al.

Dieses Ergebnis überraschte uns, da andere Methoden zur Warnung der Leser – wie etwa das Anbringen von Hinweisen nur an fragwürdige Schlagzeilen – dazu führten, dass Nutzer unbeschrifteten Schlagzeilen weniger skeptisch . Dieser Unterschied ist besonders bemerkenswert, da die Warnflagge von Facebook kaum Einfluss auf die Nutzer hatte und schließlich abgeschafft wurde . Vielleicht können Quellenbewertungen das liefern, was die Facebook-Flagge nicht konnte.

Screenshot von Antino Kim

Unsere Erkenntnisse deuten darauf hin, dass Expertenbewertungen von Unternehmen wie NewsGuard die Verbreitung von Propaganda und Desinformation wahrscheinlich effektiver reduzieren können, als wenn Benutzer die Zuverlässigkeit und Genauigkeit von Nachrichtenquellen selbst bewerten. Das macht Sinn, wenn man bedenkt, dass, wie wir es auf Buzzfeed ausdrückten, „ Crowdsourcing von ‚Nachrichten‘ der Grund war, der uns überhaupt in diesen Schlamassel gebracht hat “.

Antino Kim , Assistenzprofessor für Operations and Decision Technologies, Indiana University ; Alan R. Dennis , Professor für Internetsysteme, Indiana University ; Patricia L. Moravec , Assistenzprofessorin für Informations-, Risiko- und Betriebsmanagement, University of Texas at Austin , und Randall K. Minas , außerordentlicher Professor für Informationstechnologiemanagement, University of Hawaii

Dieser Artikel wurde von The Conversation unter einer Creative Commons-Lizenz neu veröffentlicht. Lesen Sie den Originalartikel .