La settimana scorsa il miliardario e proprietario di X, Elon Musk, ha affermato che il pool di dati generati dall’uomo utilizzati per addestrare modelli di intelligenza artificiale (AI) come ChatGPT è esaurito.

Musk non ha citato prove a sostegno di ciò. Ma altre figure di spicco del settore tecnologico hanno fatto affermazioni simili negli ultimi mesi. E ricerche precedenti indicavano che i dati generati dall’uomo si sarebbero esauriti entro due-otto anni.

Ciò è dovuto in gran parte al fatto che gli esseri umani non riescono a creare nuovi dati come testo, video e immagini abbastanza velocemente da tenere il passo con le enormi e veloci richieste dei modelli di intelligenza artificiale. Quando i dati autentici si esauriranno, rappresenterà un grosso problema sia per gli sviluppatori che per gli utenti dell’intelligenza artificiale.

Ciò costringerà le aziende tecnologiche a dipendere maggiormente dai dati generati dall’intelligenza artificiale, noti come “dati sintetici”. E questo, a sua volta, potrebbe far sì che i sistemi di intelligenza artificiale attualmente utilizzati da centinaia di milioni di persone siano meno accurati e affidabili – e quindi utili.

Ma questo non è un risultato inevitabile. Infatti, se utilizzati e gestiti con attenzione, i dati sintetici potrebbero migliorare i modelli di intelligenza artificiale.

I problemi con i dati reali

Le aziende tecnologiche dipendono dai dati, reali o sintetici, per costruire, addestrare e perfezionare modelli di intelligenza artificiale generativa come ChatGPT. La qualità di questi dati è cruciale. Dati scarsi portano a risultati scarsi, allo stesso modo in cui l’utilizzo di ingredienti di bassa qualità in cucina può produrre pasti di bassa qualità.

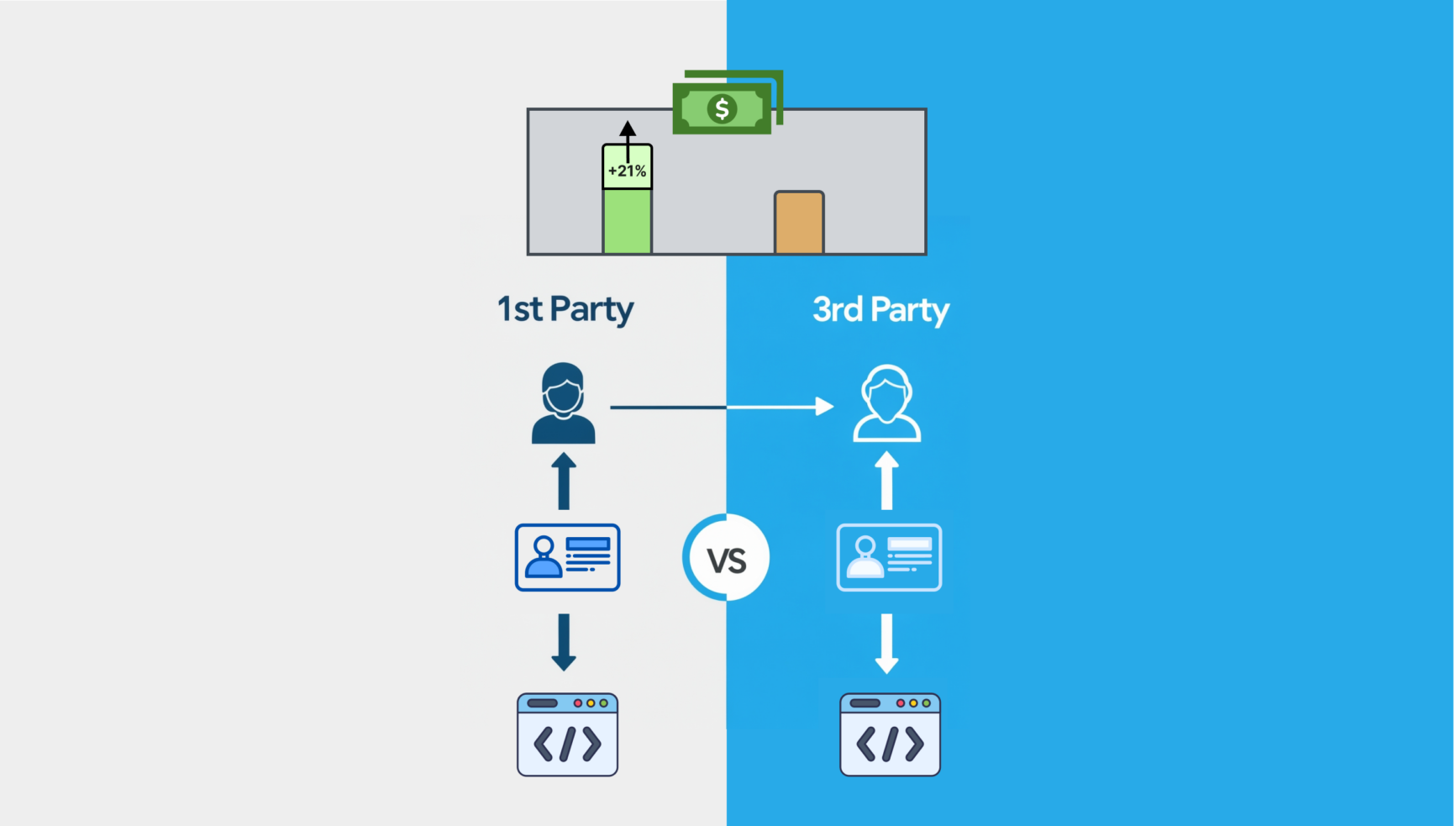

I dati reali si riferiscono a testi, video e immagini creati dagli esseri umani. Le aziende lo raccolgono attraverso metodi quali sondaggi, esperimenti, osservazioni o mining di siti Web e social media.

I dati reali sono generalmente considerati preziosi perché includono eventi reali e catturano un’ampia gamma di scenari e contesti. Tuttavia, non è perfetto.

Ad esempio, può contenere errori di ortografia e contenuti incoerenti o irrilevanti . Può anche essere fortemente distorto , il che può, ad esempio, portare a modelli di intelligenza artificiale generativa che creano immagini che mostrano solo uomini o bianchi in determinati lavori.

Questo tipo di dati richiede anche molto tempo e impegno per la preparazione. Innanzitutto, le persone raccolgono set di dati, prima di etichettarli per renderli significativi per un modello di intelligenza artificiale. Quindi esamineranno e puliranno questi dati per risolvere eventuali incoerenze, prima che i computer li filtrino, li organizzino e li convalidino.

Questo processo può richiedere fino all’80 % del tempo totale investito nello sviluppo di un sistema di intelligenza artificiale.

Ma come affermato in precedenza, anche i dati reali scarseggiano sempre più perché gli esseri umani non riescono a produrli abbastanza velocemente per soddisfare la crescente domanda di intelligenza artificiale.

L’ascesa dei dati sintetici

I dati sintetici vengono creati o generati artificialmente da algoritmi , come il testo generato da ChatGPT o un'immagine generata da DALL-E .

In teoria, i dati sintetici offrono una soluzione economica e più rapida per l’addestramento dei modelli di intelligenza artificiale.

Affronta anche problemi di privacy e questioni etiche , in particolare con informazioni personali sensibili come i dati sanitari.

È importante sottolineare che, a differenza dei dati reali, non scarseggiano. In effetti, è illimitato.

Da qui in poi sono solo dati sintetici.

— Rohan Paul (@rohanpaul_ai) 9 gennaio 2025

"La somma cumulativa della conoscenza umana è stata esaurita nella formazione sull'intelligenza artificiale. Questo è successo, sostanzialmente, l'anno scorso."

– Elon pic.twitter.com/rdPzCbvdLv

Le sfide dei dati sintetici

Per questi motivi, le aziende tecnologiche si rivolgono sempre più ai dati sintetici per addestrare i propri sistemi di intelligenza artificiale. La società di ricerca Gartner stima che entro il 2030 i dati sintetici diventeranno la principale forma di dati utilizzata nell’intelligenza artificiale.

Ma sebbene i dati sintetici offrano soluzioni promettenti, non sono esenti da sfide.

Una delle preoccupazioni principali è che i modelli di intelligenza artificiale possono “collassare” quando si basano troppo su dati sintetici. Ciò significa che iniziano a generare così tante “allucinazioni” – una risposta che contiene informazioni false – e diminuiscono così tanto in termini di qualità e prestazioni da essere inutilizzabili.

Ad esempio, i modelli di intelligenza artificiale hanno già difficoltà a scrivere correttamente alcune parole. Se questi dati pieni di errori vengono utilizzati per addestrare altri modelli, anch’essi sono destinati a replicare gli errori.

Contenuti dei nostri partner

I dati sintetici comportano anche il rischio di essere eccessivamente semplicistici . Potrebbe essere privo dei dettagli sfumati e della diversità riscontrabili nei set di dati reali, il che potrebbe far sì che anche i risultati dei modelli di intelligenza artificiale addestrati su di esso siano eccessivamente semplicistici e meno utili.

Creare sistemi robusti per mantenere l’intelligenza artificiale accurata e affidabile

Per affrontare questi problemi, è essenziale che organismi e organizzazioni internazionali come l’ Organizzazione internazionale per la standardizzazione o l’ Unione internazionale delle telecomunicazioni introducano sistemi robusti per il monitoraggio e la convalida dei dati di addestramento dell’IA e garantiscano che i sistemi possano essere implementati a livello globale.

I sistemi di intelligenza artificiale possono essere attrezzati per tracciare i metadati, consentendo agli utenti o ai sistemi di tracciare le origini e la qualità di tutti i dati sintetici su cui sono stati addestrati. Ciò completerebbe un sistema di tracciamento e convalida standard a livello globale.

Gli esseri umani devono inoltre mantenere la supervisione dei dati sintetici durante tutto il processo di addestramento di un modello di intelligenza artificiale per garantire che sia di alta qualità. Questa supervisione dovrebbe includere la definizione degli obiettivi, la convalida della qualità dei dati, la garanzia del rispetto degli standard etici e il monitoraggio delle prestazioni del modello di intelligenza artificiale.

Per ironia della sorte, gli algoritmi di intelligenza artificiale possono anche svolgere un ruolo nel controllo e nella verifica dei dati, garantendo l’accuratezza dei risultati generati dall’intelligenza artificiale da altri modelli. Ad esempio, questi algoritmi possono confrontare dati sintetici con dati reali per identificare eventuali errori o discrepanze e garantire che i dati siano coerenti e accurati. Quindi, in questo modo, i dati sintetici potrebbero portare a modelli di intelligenza artificiale migliori.

Il futuro dell’intelligenza artificiale dipende da dati di alta qualità . I dati sintetici svolgeranno un ruolo sempre più importante nel superare la carenza di dati.

Tuttavia, il suo utilizzo deve essere gestito con attenzione per mantenere la trasparenza, ridurre gli errori e preservare la privacy, garantendo che i dati sintetici fungano da supplemento affidabile ai dati reali, mantenendo i sistemi di intelligenza artificiale accurati e affidabili.

James Jin Kang, docente senior di informatica, Università RMIT Vietnam .

Questo articolo è ripubblicato da The Conversation sotto una licenza Creative Commons. Leggi l' articolo originale .