hevdet milliardæren og eieren av X, Elon Musk, at mengden av menneskeskapte data som brukes til å trene kunstig intelligens (AI)-modeller som ChatGPT er tom.

Musk siterte ikke bevis for å støtte dette. Men andre ledende figurer i teknologibransjen har kommet med lignende påstander de siste månedene. Og tidligere forskning indikerte menneskeskapte data ville gå tom innen to til åtte år.

Dette er i stor grad fordi mennesker ikke kan lage nye data som tekst, video og bilder raskt nok til å holde tritt med de raske og enorme kravene til AI-modeller. Når ekte data går tom, vil det utgjøre et stort problem for både utviklere og brukere av AI.

Det vil tvinge teknologiselskaper til å være mer avhengige av data generert av AI, kjent som "syntetiske data". Og dette kan igjen føre til at AI-systemene som for tiden brukes av hundrevis av millioner mennesker er mindre nøyaktige og pålitelige – og derfor nyttige.

Men dette er ikke et uunngåelig resultat. Faktisk, hvis brukt og administrert med omhu, kan syntetiske data forbedre AI-modeller.

Problemene med ekte data

Teknologiselskaper er avhengige av data – ekte eller syntetiske – for å bygge, trene og foredle generative AI-modeller som ChatGPT. Kvaliteten på disse dataene er avgjørende. Dårlige data fører til dårlige resultater, på samme måte kan bruk av ingredienser av lav kvalitet i matlagingen gi måltider av lav kvalitet.

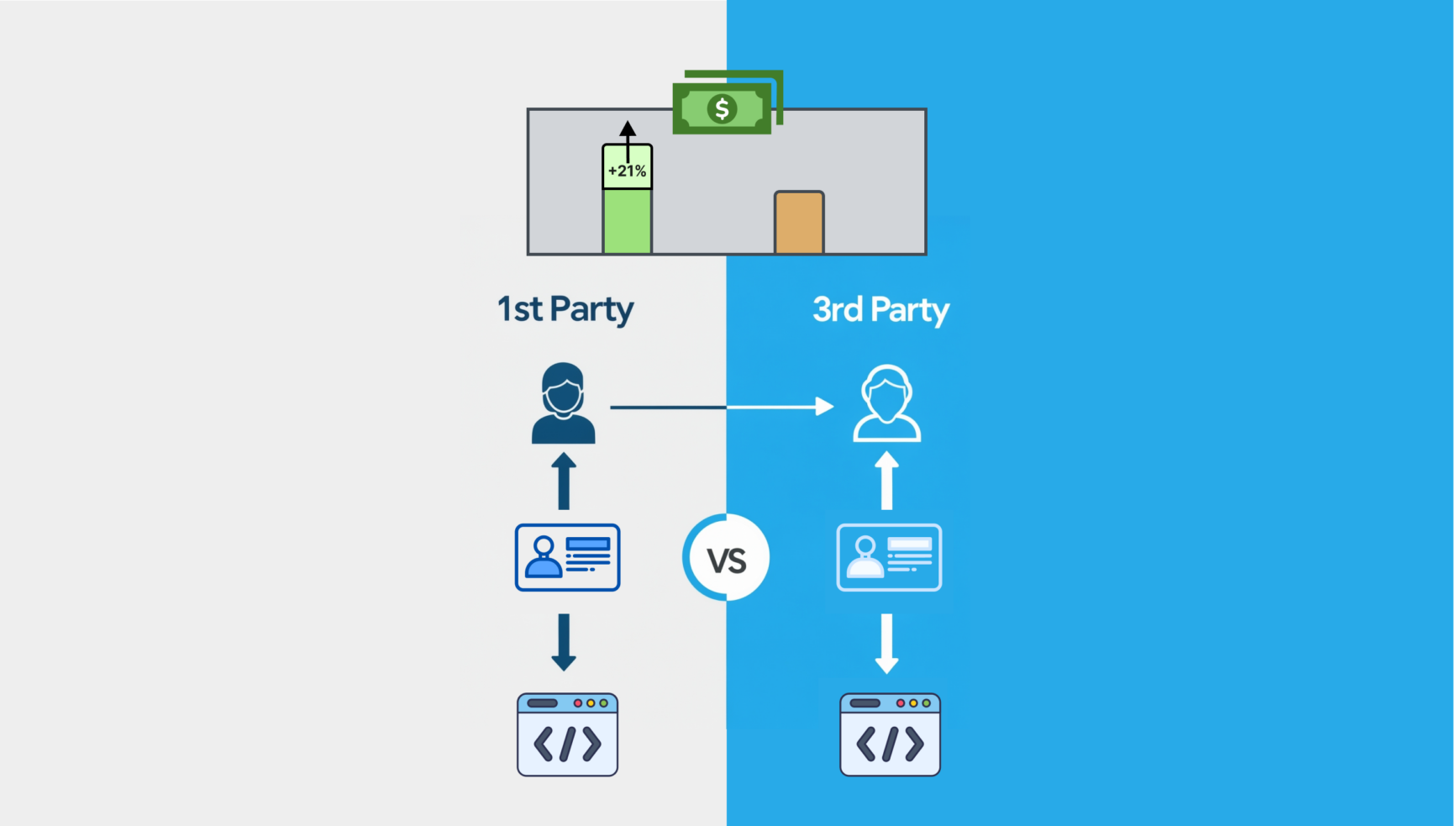

Ekte data refererer til tekst, video og bilder laget av mennesker. Bedrifter samler det inn gjennom metoder som undersøkelser, eksperimenter, observasjoner eller gruvedrift av nettsider og sosiale medier.

Ekte data anses generelt som verdifulle fordi de inkluderer sanne hendelser og fanger opp et bredt spekter av scenarier og sammenhenger. Det er imidlertid ikke perfekt.

Den kan for eksempel inneholde stavefeil og inkonsekvent eller irrelevant innhold . Det kan også være sterkt partisk , noe som for eksempel kan føre til at generative AI-modeller lager bilder som kun viser menn eller hvite mennesker i visse jobber.

Denne typen data krever også mye tid og krefter å forberede. Først samler folk inn datasett, før de merker dem for å gjøre dem meningsfulle for en AI-modell. De vil deretter gjennomgå og rense disse dataene for å løse eventuelle inkonsekvenser, før datamaskiner filtrerer, organiserer og validerer dem.

Denne prosessen kan ta opptil 80 % av den totale tidsinvesteringen i utviklingen av et AI-system.

Men som nevnt ovenfor er det også stadig mer mangel på fordi mennesker ikke kan produsere dem raskt nok til å mate den voksende AI-etterspørselen.

Fremveksten av syntetiske data

Syntetiske data er kunstig opprettet eller generert av algoritmer , for eksempel tekst generert av ChatGPT eller et bilde generert av DALL-E .

I teorien tilbyr syntetiske data en kostnadseffektiv og raskere løsning for trening av AI-modeller.

Den tar også opp personvernproblemer og etiske spørsmål , spesielt med sensitiv personlig informasjon som helsedata.

Viktigere, i motsetning til ekte data er det ikke mangelvare. Faktisk er det ubegrenset.

Herfra er det eneste syntetiske data.

— Rohan Paul (@rohanpaul_ai) 9. januar 2025

"Den kumulative summen av menneskelig kunnskap har blitt oppbrukt i AI-trening. Det skjedde i utgangspunktet i fjor."

– Elon pic.twitter.com/rdPzCbvdLv

Utfordringene med syntetiske data

Av disse grunnene tyr teknologiselskaper i økende grad til syntetiske data for å trene AI-systemene sine. Forskningsfirmaet Gartner anslår at innen 2030 vil syntetiske data bli hovedformen for data som brukes i AI.

Men selv om syntetiske data tilbyr lovende løsninger, er det ikke uten utfordringer.

En primær bekymring er at AI-modeller kan "kollapse" når de stoler for mye på syntetiske data. Dette betyr at de begynner å generere så mange "hallusinasjoner" - et svar som inneholder falsk informasjon - og avtar så mye i kvalitet og ytelse at de er ubrukelige.

For eksempel sliter AI-modeller allerede med å stave noen ord riktig. Hvis disse feilfylte dataene brukes til å trene andre modeller, er de også nødt til å replikere feilene.

Innhold fra våre partnere

Syntetiske data innebærer også en risiko for å være for forenklede . Det kan være blottet for de nyanserte detaljene og mangfoldet som finnes i ekte datasett, noe som kan føre til at utdataene fra AI-modeller som er trent på det, også blir for forenklede og mindre nyttige.

Opprette robuste systemer for å holde AI nøyaktig og pålitelig

For å løse disse problemene er det viktig at internasjonale organer og organisasjoner som International Organization for Standardization eller FNs internasjonale telekommunikasjonsunion innfører robuste systemer for sporing og validering av AI-treningsdata, og sikrer at systemene kan implementeres globalt.

AI-systemer kan utstyres for å spore metadata, slik at brukere eller systemer kan spore opprinnelsen og kvaliteten til alle syntetiske data de har blitt trent på. Dette vil utfylle et globalt standard sporings- og valideringssystem.

Mennesker må også ha tilsyn med syntetiske data gjennom hele opplæringsprosessen til en AI-modell for å sikre at den er av høy kvalitet. Dette tilsynet bør inkludere å definere mål, validere datakvalitet, sikre overholdelse av etiske standarder og overvåke ytelsen til AI-modeller.

Litt ironisk nok kan AI-algoritmer også spille en rolle i revisjon og verifisering av data, og sikrer nøyaktigheten til AI-genererte utdata fra andre modeller. For eksempel kan disse algoritmene sammenligne syntetiske data med ekte data for å identifisere eventuelle feil eller avvik for å sikre at dataene er konsistente og nøyaktige. Så på denne måten kan syntetiske data føre til bedre AI-modeller.

Fremtiden til AI avhenger av data av høy kvalitet . Syntetiske data vil spille en stadig viktigere rolle for å overvinne datamangel.

Bruken må imidlertid håndteres nøye for å opprettholde åpenhet, redusere feil og bevare personvernet – for å sikre at syntetiske data fungerer som et pålitelig supplement til ekte data, og holder AI-systemer nøyaktige og pålitelige.

James Jin Kang, universitetslektor i informatikk, RMIT University Vietnam .

Denne artikkelen er publisert på nytt fra The Conversation under en Creative Commons-lisens. Les originalartikkelen .