Kinas nye DeepSeek Large Language Model (LLM) har forstyrret det USA-dominerte markedet , og tilbyr en relativt høy ytelse chatbot-modell til betydelig lavere pris.

De reduserte kostnadene for utvikling og lavere abonnementspriser sammenlignet med oss AI -verktøy bidro til at den amerikanske chipprodusenten NVIDIA tapte 600 milliarder dollar (480 milliarder pund) i markedsverdi over en dag. Nvidia gjør at datamaskinbrikkene som brukes til å trene flertallet av LLM -er, den underliggende teknologien som brukes i ChatGPT og andre AI -chatbots. DeepSeek bruker billigere NVIDIA H800-brikker over de dyrere topp moderne versjonene.

ChatGPT -utvikler Openai brukte angivelig et sted mellom 100 millioner dollar og 1 milliard dollar på utviklingen av en veldig nylig versjon av produktet kalt O1. Derimot oppnådde DeepSeek sin trening på bare to måneder til en pris av 5,6 millioner dollar ved å bruke en serie smarte innovasjoner.

Men hvor godt sammenligner DeepSeeks AI Chatbot, R1, med andre, lignende AI -verktøy på ytelse?

DeepSeek hevder at modellene presterer sammenlignbart med Openais tilbud, til og med overskrider O1 -modellen i visse referansetester. Benchmarks som bruker Massive Multitask Language Understanding (MMLU) tester evaluerer imidlertid kunnskap på tvers av flere fag ved hjelp av flervalgsspørsmål. Mange LLM-er er trent og optimalisert for slike tester, noe som gjør dem upålitelige som sanne indikatorer på ytelse i den virkelige verden.

En alternativ metodikk for objektiv evaluering av LLMS bruker et sett med tester utviklet av forskere ved Cardiff Metropolitan, Bristol og Cardiff universiteter - kjent som Knowledge Observation Group (KOG). Disse testene undersøker LLMS 'evne til å etterligne menneskelig språk og kunnskap gjennom spørsmål som krever implisitt menneskelig forståelse for å svare på. Kjernetestene holdes hemmelige for å unngå at LLM -selskaper trener modellene sine for disse testene.

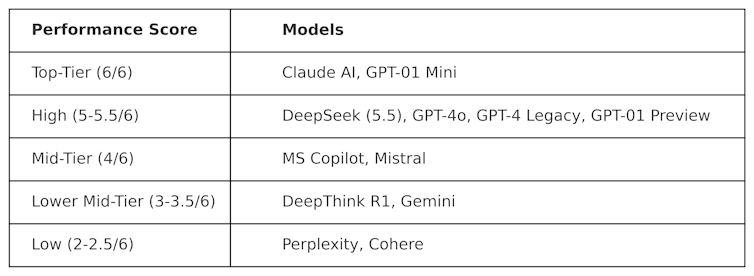

Kog distribuerte offentlige tester inspirert av arbeid av Colin Fraser, en dataforsker ved Meta , for å evaluere DeepSeek mot andre LLM -er. Følgende resultater ble observert:

Testene som brukes til å produsere denne tabellen er "motstridende" i naturen. De er med andre ord designet for å være "harde" og for å teste LLM -er på en måte som ikke er sympatiske for hvordan de er designet. Dette betyr at ytelsen til disse modellene i denne testen sannsynligvis vil være forskjellig fra ytelsen deres i mainstream benchmarking -tester.

DeepSeek scoret 5,5 av 6, og overgikk Openais O1-dens avanserte resonnement (kjent som "-kjede") -modellen-samt ChatGPT-4O, den gratis versjonen av ChatGPT. Men DeepSeek ble marginalt utkonkurrert av Anthropics Claudei og Openais O1 Mini, som begge scoret en perfekt 6/6. Det er interessant at O1 underpresterte mot sin "mindre" motstykke, O1 Mini.

Dypthink R1-et tankert AI-verktøy laget av DeepSeek-underprestert i forhold til DeepSeek med en poengsum på 3,5.

Dette resultatet viser hvor konkurrerende DeepSeeks chatbot allerede er, og slår Openais flaggskipsmodeller. Det vil sannsynligvis anspore videre utvikling for DeepSeek, som nå har et sterkt fundament å bygge videre på. Det kinesiske teknologiselskapet har imidlertid ett alvorlig problem de andre LLM -ene ikke gjør det: sensur.

Sensur utfordringer

Til tross for sin sterke ytelse og popularitet, har DeepSeek møtt kritikk over svarene på politisk følsomme temaer i Kina. For eksempel blir spørsmål relatert til Tiananmen Square, Taiwan, Uyghur muslimer og demokratiske bevegelser møtt med svaret: "Beklager, det er utenfor mitt nåværende omfang."

Men dette problemet er ikke nødvendigvis unikt for DeepSeek, og potensialet for politisk innflytelse og sensur i LLM -er mer generelt er en økende bekymring. Kunngjøringen om Donald Trumps 500 milliarder dollar Stargate LLM -prosjekt , som involverer Openai, Nvidia, Oracle, Microsoft og Arm, reiser også frykt for politisk innflytelse.

I tillegg antyder Metas nylige beslutning om å forlate faktasjekking på Facebook og Instagram en økende trend mot populisme over sannhet.

Innhold fra våre partnere

DeepSeeks ankomst har forårsaket alvorlig forstyrrelse av LLM -markedet. Amerikanske selskaper som Openai og Anthropic vil bli tvunget til å innovere produktene sine for å opprettholde relevans og samsvare med ytelsen og kostnadene.

DeepSeeks suksess utfordrer allerede status quo, og viser at LLM-modeller med høy ytelse kan utvikles uten milliard dollar budsjetter. Det fremhever også risikoen for LLM -sensur, spredning av feilinformasjon og hvorfor uavhengige evalueringer betyr noe.

Etter hvert som LLM -er blir dypere innebygd i global politikk og næringsliv, vil åpenhet og ansvarlighet være avgjørende for å sikre at fremtiden til LLMS er trygg, nyttig og pålitelig.

Simon Thorne, senior foreleser i databehandlings- og informasjonssystemer, Cardiff Metropolitan University

Denne artikkelen blir utgitt fra samtalen under en Creative Commons -lisens. Les den opprinnelige artikkelen .