sinabi ng bilyunaryo at may-ari ng X na si Elon Musk na ang pool ng data na nabuo ng tao na ginagamit upang sanayin ang mga modelo ng artificial intelligence (AI) gaya ng ChatGPT.

Ang Musk ay hindi nagbanggit ng ebidensya upang suportahan ito. Ngunit ang iba pang nangungunang mga numero sa industriya ng tech ay gumawa ng mga katulad na claim sa mga nakaraang buwan. At ang naunang pananaliksik ay nagpahiwatig na ang data na nabuo ng tao ay mauubos sa loob ng dalawa hanggang walong taon.

Ito ay higit sa lahat dahil ang mga tao ay hindi makakagawa ng bagong data tulad ng teksto, video at mga larawan nang sapat na mabilis upang makasabay sa mabilis at napakalaking pangangailangan ng mga modelo ng AI. Kapag naubos ang tunay na data, magpapakita ito ng malaking problema para sa parehong mga developer at user ng AI.

Pipilitin nito ang mga tech na kumpanya na umasa nang higit sa data na nabuo ng AI, na kilala bilang "synthetic data". At ito, sa turn, ay maaaring humantong sa mga sistema ng AI na kasalukuyang ginagamit ng daan-daang milyong tao na hindi gaanong tumpak at maaasahan - at samakatuwid, kapaki-pakinabang.

Ngunit ito ay hindi isang hindi maiiwasang kinalabasan. Sa katunayan, kung gagamitin at maingat na pinamamahalaan, ang synthetic na data ay maaaring mapabuti ang mga modelo ng AI.

Ang mga problema sa totoong data

Ang mga tech na kumpanya ay umaasa sa data – totoo o sintetiko – upang bumuo, magsanay at magpino ng mga generative na modelo ng AI gaya ng ChatGPT. Ang kalidad ng data na ito ay mahalaga. Ang mahinang data ay humahantong sa mga mahihirap na output, sa parehong paraan ang paggamit ng mababang kalidad na mga sangkap sa pagluluto ay maaaring makagawa ng mga mababang kalidad na pagkain.

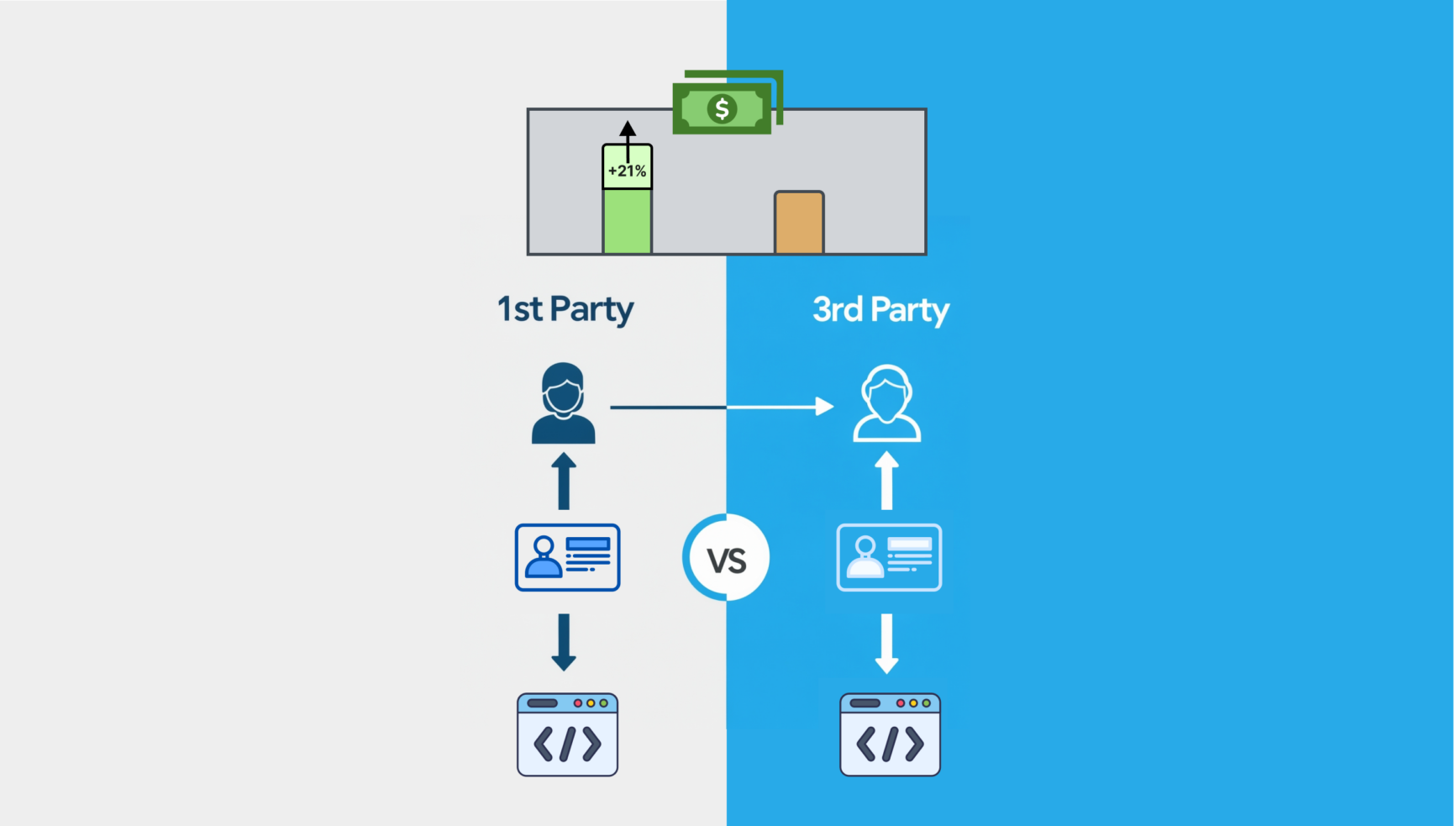

Ang totoong data ay tumutukoy sa teksto, video at mga larawang nilikha ng mga tao. Kinokolekta ito ng mga kumpanya sa pamamagitan ng mga pamamaraan tulad ng mga survey, eksperimento, obserbasyon o pagmimina ng mga website at social media.

Ang totoong data ay karaniwang itinuturing na mahalaga dahil kabilang dito ang mga totoong kaganapan at kumukuha ng malawak na hanay ng mga sitwasyon at konteksto. Gayunpaman, hindi ito perpekto.

Halimbawa, maaari itong maglaman ng mga error sa spelling at hindi pare-pareho o walang kaugnayang nilalaman . Maaari rin itong maging mabigat na bias , na maaaring, halimbawa, ay humantong sa mga generative na modelo ng AI na lumilikha ng mga larawan na nagpapakita lamang ng mga lalaki o puting tao sa ilang partikular na trabaho.

Ang ganitong uri ng data ay nangangailangan din ng maraming oras at pagsisikap upang maghanda. Una, kinokolekta ng mga tao ang mga dataset, bago lagyan ng label ang mga ito para maging makabuluhan ang mga ito para sa isang modelo ng AI. Pagkatapos ay susuriin at lilinisin nila ang data na ito upang malutas ang anumang mga hindi pagkakapare-pareho, bago ito i-filter, ayusin at patunayan ng mga computer.

Ang prosesong ito ay maaaring tumagal ng hanggang 80% ng kabuuang oras na pamumuhunan sa pagbuo ng isang AI system.

Ngunit gaya ng nasabi sa itaas, ang totoong data ay kulang din sa supply dahil hindi ito kayang gawin ng mga tao nang mabilis para mapakain ang lumalaking pangangailangan ng AI.

Ang pagtaas ng sintetikong data

Ang sintetikong data ay artipisyal na nilikha o nabuo ng mga algorithm , tulad ng text na nabuo ng ChatGPT o isang imahe na nabuo ng DALL-E .

Sa teorya, nag-aalok ang synthetic data ng cost-effective at mas mabilis na solusyon para sa pagsasanay ng mga modelo ng AI.

Tinutugunan din nito ang mga alalahanin sa privacy at mga isyung etikal , partikular na sa sensitibong personal na impormasyon tulad ng data ng kalusugan.

Ang mahalaga, hindi tulad ng totoong data, hindi ito kulang. Sa katunayan, ito ay walang limitasyon.

Mula dito sa tanging Synthetic data nito.

— Rohan Paul (@rohanpaul_ai) Enero 9, 2025

"Naubos na ang pinagsama-samang kabuuan ng kaalaman ng tao sa pagsasanay sa AI. Nangyari iyon, karaniwang, noong nakaraang taon."

– Elon pic.twitter.com/rdPzCbvdLv

Ang mga hamon ng sintetikong data

Para sa mga kadahilanang ito, ang mga tech na kumpanya ay lalong lumilipat sa sintetikong data upang sanayin ang kanilang mga AI system. Tinatantya ng research firm na Gartner na sa 2030, ang sintetikong data ay magiging pangunahing anyo ng data na ginagamit sa AI.

Ngunit bagama't nag-aalok ang sintetikong data ng mga magagandang solusyon, hindi ito walang mga hamon.

Ang isang pangunahing alalahanin ay ang mga modelo ng AI ay maaaring "mag-collapse" kapag masyado silang umaasa sa synthetic na data. Nangangahulugan ito na nagsisimula silang bumuo ng napakaraming "mga guni-guni" - isang tugon na naglalaman ng maling impormasyon - at bumaba nang husto sa kalidad at pagganap na hindi na magagamit ang mga ito.

Halimbawa, nahihirapan na sa pagbaybay nang tama ng ilang salita. Kung ang data na ito na puno ng pagkakamali ay ginagamit upang sanayin ang iba pang mga modelo, tiyak na gagayahin din nila ang mga error.

Nilalaman mula sa aming mga kasosyo

Ang sintetikong data ay nagdadala rin ng panganib na maging sobrang simple . Maaaring wala ito sa mga nuanced na detalye at pagkakaiba-iba na makikita sa mga totoong dataset, na maaaring magresulta sa pagiging sobrang simplistic at hindi gaanong kapaki-pakinabang ang output ng mga modelong AI na sinanay dito.

Paglikha ng mga matatag na system para mapanatiling tumpak at mapagkakatiwalaan ang AI

Para matugunan ang mga isyung ito, mahalagang ang mga internasyonal na katawan at organisasyon gaya ng International Organization for Standardization International Telecommunication Union ng United Nations ay magpakilala ng mga matatag na sistema para sa pagsubaybay at pagpapatunay ng data ng pagsasanay sa AI, at tiyaking maipapatupad ang mga system sa buong mundo.

Ang mga AI system ay maaaring magamit upang subaybayan ang metadata, na nagpapahintulot sa mga user o system na masubaybayan ang mga pinagmulan at kalidad ng anumang sintetikong data kung saan ito pinagsanayan. Makakadagdag ito sa isang pandaigdigang karaniwang sistema ng pagsubaybay at pagpapatunay.

Dapat ding panatilihin ng mga tao ang pangangasiwa sa sintetikong data sa buong proseso ng pagsasanay ng isang modelo ng AI upang matiyak na ito ay may mataas na kalidad. Dapat kasama sa pangangasiwa na ito ang pagtukoy ng mga layunin, pagpapatunay ng kalidad ng data, pagtiyak ng pagsunod sa mga pamantayang etikal at pagsubaybay sa pagganap ng modelo ng AI.

Medyo ironically, ang mga algorithm ng AI ay maaari ding gumanap ng papel sa pag-audit at pag-verify ng data, na tinitiyak ang katumpakan ng mga output na binuo ng AI mula sa iba pang mga modelo. Halimbawa, maaaring ihambing ng mga algorithm na ito ang sintetikong data laban sa totoong data upang matukoy ang anumang mga error o pagkakaiba upang matiyak na pare-pareho at tumpak ang data. Kaya sa paraang ito, maaaring humantong ang sintetikong data sa mas mahuhusay na modelo ng AI.

Ang hinaharap ng AI ay nakasalalay sa mataas na kalidad na data . Ang sintetikong data ay gaganap ng lalong mahalagang papel sa pagtagumpayan ng mga kakulangan sa data.

Gayunpaman, ang paggamit nito ay dapat na maingat na pinamamahalaan upang mapanatili ang transparency, bawasan ang mga error at mapanatili ang privacy - tinitiyak na ang sintetikong data ay nagsisilbing isang maaasahang suplemento sa totoong data, na pinapanatili ang mga AI system na tumpak at mapagkakatiwalaan.

James Jin Kang, Senior Lecturer sa Computer Science, RMIT University Vietnam .

Ang artikulong ito ay muling nai-publish mula sa The Conversation sa ilalim ng lisensya ng Creative Commons. Basahin ang orihinal na artikulo .